本文主要简单介绍了集成学习的基本概念,优缺点,应用场景,实现方法,以及bagging, boosting, 堆叠法三种集成学习的建模过程,示例和模型参数等。

”集成学习 Python AdaBoost Bagging“ 的搜索结果

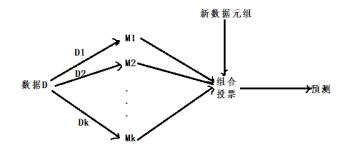

集成学习 (Ensemble Learning)通过构建并结合多个学习器来完成学习任务,有时也被称为多分类器系统( Multi-classifier System)、基于委员会的学习( Committee-based Learning)等。 上图显示出集成学习的一般...

2.初级学习器的输出类概率作为次级学习器的输入属性 3.用多响应回归(Multi-response linear regression,MLR)作为次级 1.

集成学习(Ensemble Learning),通过构建并结合多个学习器来完成学习任务。一般结构是:先产生一组“个体学习器”,再用某种策略将它们结合起来。结合策略主要有平均法、投票法和学习法等。因此,有时也称集成学习...

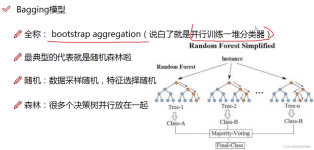

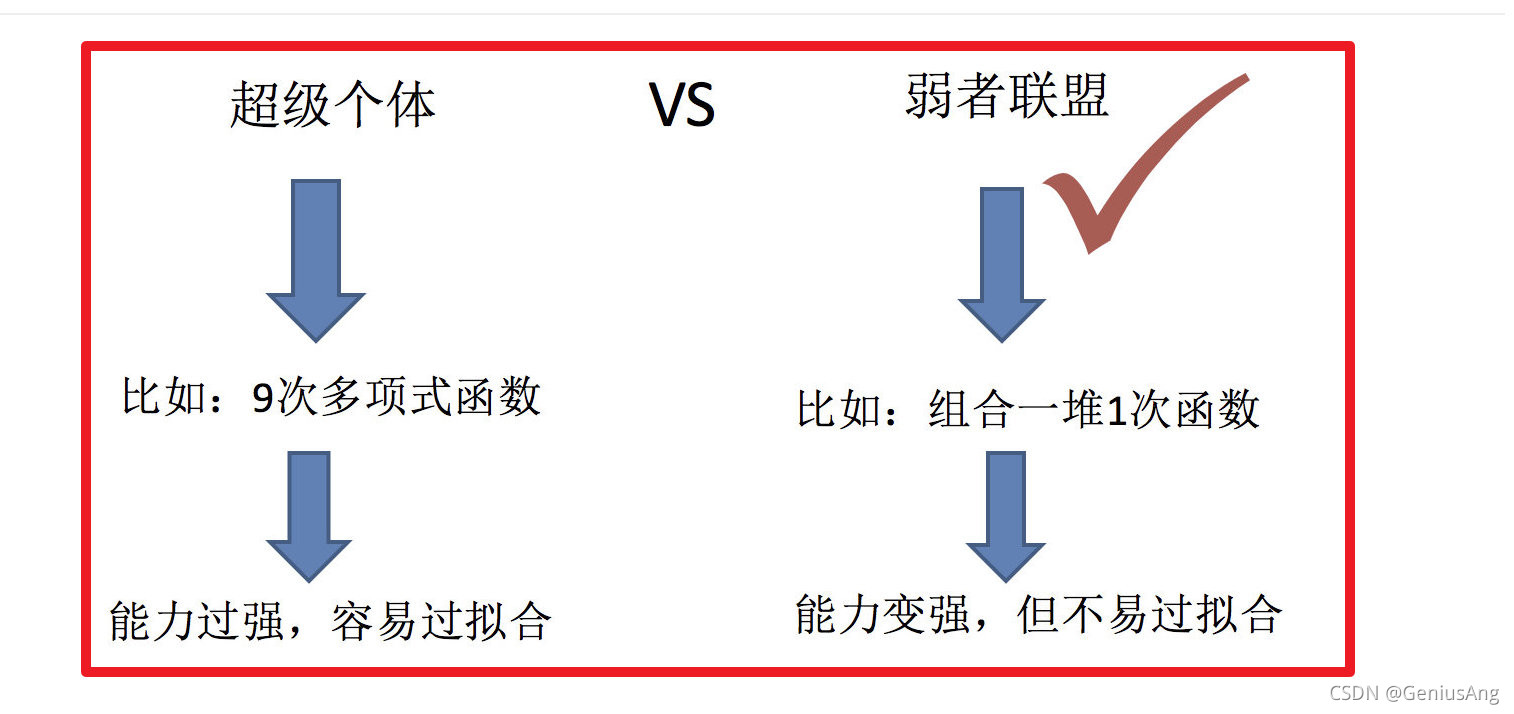

集成学习(Ensemble Learning)有时也被笼统地称作提升(Boosting)方法,广泛用于分类和回归任务。它最初的思想很简单:使用一些(不同的)方法改变原始训练样本的分布,从而构建多个不同的分类器,并将这些分类器...

在机器学习的有监督学习算法中,我们的目标是...集成学习即组合多个弱监督模型以期望得到一个更好更全面的强监督模型。集成学习潜在的思想是即便某一个弱分类器得到了错误的预测,其他的弱分类器也可以将错误纠正回来。

我们在《集成学习(一):基础知识》中提到,欲得到泛化性能强的集成,集成中的个体学习器应尽可能相互独立;虽然“独立”在现实任务中无法做到,但可以设法使基学习器尽可能具有较大的差异。 给定一个训练数据集,...

这族算法的工作机制类似:先从初始训练集训练出一个基学习器,再根据基学习器的表现对训练样本分布进行调整,使得先前基学习器做错的训练样本在后续受到更多关注,然后基于调整后的样本分布来训练下一个基学习器;...

集成学习算法简介1.1 什么是集成学习1.2 2 复习:机器学习的两个核心任务1.3 3 集成学习中boosting和Bagging1.4 小结2. Bagging和随机森林2.1 Bagging集成原理2.2 随机森林构造过程2.3 随机森林api介绍2.4 随机森林...

集成学习就是"博采众长",将一组弱学习器通过一定方法给合在一起得到强学习器,这个强学习器的泛化能力相对任何一个弱学习器都要好,甚至还有起到三个臭皮匠,赛过诸葛亮的效果 这里有2个问题,有哪些弱学习器可以用...

推荐文章

- 机器学习之超参数优化 - 网格优化方法(随机网格搜索)_网格搜索参数优化-程序员宅基地

- Lumina网络进入SDN市场-程序员宅基地

- python引用传递的区别_php传值引用的区别-程序员宅基地

- 《TCP/IP详解 卷2》 笔记: 简介_tcpip详解卷二有必要看吗-程序员宅基地

- 饺子播放器Jzvd使用过程中遇到的问题汇总-程序员宅基地

- python- flask current_app详解,与 current_app._get_current_object()的区别以及异步发送邮件实例-程序员宅基地

- 堪比ps的mac修图软件 Pixelmator Pro 2.0.6中文版 支持Silicon M1_pixelmator堆栈-程序员宅基地

- 「USACO2015」 最大流 - 树上差分_usaco 差分-程序员宅基地

- Leetcode #315: 计算右侧小于当前元素的个数_找元素右边比他小的数字-程序员宅基地

- HTTP图解读书笔记(第六章 HTTP首部)响应首部字段_web响应的首部内容-程序员宅基地